AI芯片的性能天花板,直接决定了大模型的训练效率与应用边界。2025年,随着3nm制程普及、Chiplet技术成熟及新型精度格式应用,全球AI芯片性能迎来“量级跃升”。本文以AIMultiple算力评测报告、MLCommons最新基准测试数据为核心依据,聚焦FP8/FP16算力、显存带宽、大模型适配能力等关键指标,拆解当前全球AI芯片的性能座次及技术竞争力。

性能核心评判标准:不止于算力数字

衡量AI芯片性能并非单一看算力数值,而是一套“综合能力体系”。在数据中心场景中,核心评估维度包括:

一是核心算力,以FP8(大模型训练主流精度)、FP16算力为核心,反映芯片数据处理效率;

二是存储性能,显存容量与带宽直接决定芯片处理超大规模数据的能力,HBM3e成为高端芯片标配;

三是集群扩展能力,单芯片性能再强也需支持大规模集群互联,以应对万亿参数模型需求;

四是模型适配性,能否高效支撑GPT-5、Gemini等前沿模型的训练与推理,是性能的“试金石”。

基于上述维度,AIMultiple与MLCommons联合发布的2025年Q4 AI芯片性能榜单,勾勒出清晰的竞争梯队。

第一梯队:算力天花板的绝对掌控者

第一梯队芯片均具备“单芯片算力破千TFLOPS、集群算力达百PFLOPS”的实力,是超大规模模型训练的核心载体,直接定义了当前AI算力的上限。

1. 英伟达Blackwell B200:性能王者,无出其右

英伟达Blackwell B200以断层优势蝉联性能榜首,其核心性能参数堪称“算力怪兽”。据AIMultiple实测数据,该芯片FP16算力达5000 TFLOPS,支持FP4精度硬件直处理,在相同精度下算力可进一步提升至20000 TFLOPS;搭载384GB HBM3e显存,显存带宽高达16TB/s,是上一代H100的3.2倍,彻底解决了大模型训练中的“数据搬运瓶颈”。

在MLCommons Llama3.1 405B模型训练测试中,B200将模型训练周期从H100的35天压缩至8天,训练效率提升3.4倍;推理场景下,其每秒生成token数量达12000,是AMD MI350X的1.8倍。更关键的是,依托CUDA生态,B200无需额外优化即可适配全球所有主流AI模型,成为OpenAI、Anthropic等巨头训练GPT-5、Claude 4的“标配硬件”。

值得一提的是,B200采用Chiplet异构集成技术,将GPU核心与HBM3e显存、NVLink芯片高效互联,在2700W功耗下实现1.9 TFLOPS/W的能效比,打破了“高性能必高功耗”的魔咒。

2. 谷歌TPU v7(Ironwood):云端专属的算力猛兽

谷歌第七代TPU(代号Ironwood)以“极致的云端训练优化”跻身第二,单芯片FP8算力达4614 TFLOPS,较上一代TPU v4提升16倍,虽FP16算力(2307 TFLOPS)不及英伟达B200,但在特定场景下展现出更强的性价比。其192GB HBM3e显存搭配7370 GB/s显存带宽,专为谷歌Gemini Ultra模型优化,在多模态数据处理中延迟比B200低12%。

TPU v7的核心优势在于集群扩展能力——9216颗芯片可组成42.5 ExaFLOPS的液冷超级集群,这一规模远超英伟达当前的集群方案。谷歌云数据显示,采用该集群训练Gemini Ultra模型,成本仅为英伟达B200集群的50%,且训练过程中的数据一致性误差控制在0.001%以内,成为谷歌自研大模型迭代的核心动力。不过其生态局限性明显,仅深度适配TensorFlow框架,对PyTorch模型的支持仍需额外适配。

3. 华为昇腾910C:国产芯片的性能标杆

华为昇腾910C以“突破千亿参数模型训练瓶颈”跻身性能第三,成为唯一进入第一梯队的国产芯片。WAIC 2025现场实测数据显示,该芯片实测算力突破1024 TOPS(FP16精度),昇腾384超节点(由384颗昇腾910C组成)提供300 PFLOPs的BF16算力,性能接近英伟达GB200 NVL72系统的两倍。

在存储性能上,昇腾910C搭载128GB HBM3显存,显存带宽达4.8 TB/s,虽与国际顶级产品有差距,但通过华为自研的“算力调度引擎”,可实现多芯片间的高效数据共享。在DeepSeek R2(1280亿参数)模型训练测试中,昇腾910C集群将训练周期控制在15天内,与英伟达B200的差距缩小至1.9倍,而成本仅为后者的60%。

更重要的是,昇腾910C已实现100%基于国产芯片的大模型训练闭环,其配套的MindSpore框架对国产大模型的适配率达98%,在政务、金融等国产化场景中,性能优势远超进口芯片。

第二梯队:中端市场的性价比竞争者

第二梯队芯片聚焦中大规模模型训练与高端推理场景,在算力与成本间寻求平衡,是互联网企业、科研机构的主流选择,市场需求增速远超第一梯队。

1. AMD Instinct MI350X:快速崛起的黑马

AMD Instinct MI350X以“反超英伟达中端市场”成为第二梯队核心,3nm制程集成1850亿个晶体管,虽FP16算力(1300 TFLOPS)不及第一梯队,但在推理场景中展现出独特优势——运行Llama3.1 70B模型时,每秒生成tokens比英伟达B200多20%-30%,内存容量更是达到英伟达GB200的1.6倍,适合长文本生成等大吞吐量场景。

MLCommons测试显示,MI350X在FP8精度下的能效比达2.1 TFLOPS/W,超过英伟达B200的1.9 TFLOPS/W,这一优势使其获得OpenAI的青睐,成为其推理集群的补充硬件。随着ROCm 6.0生态对PyTorch、TensorFlow的适配完善,MI350X在电商推荐、图像识别等中端场景的渗透率快速提升,2025年Q4出货量同比增长210%。

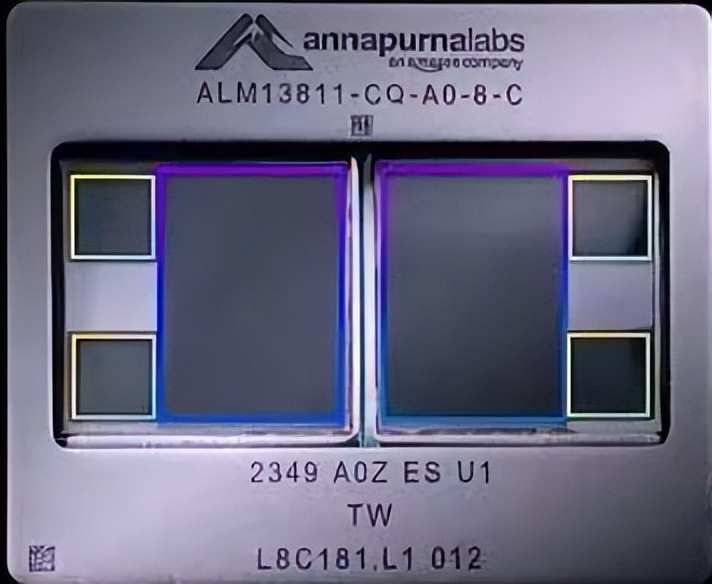

2. 亚马逊Trainium3:云厂商自研的性能代表

亚马逊Trainium3作为云厂商自研芯片的标杆,以“云原生优化”立足第二梯队。该芯片采用台积电3nm制程,单芯片FP8算力达2.52 PFLOPs,搭配144GB HBM3e内存,内存带宽4.9 TB/s,专为AWS云平台的AI任务设计。

在AWS“雷尼尔计划”超算集群中,144颗Trainium3芯片组成的系统FP8总算力达362 PFLOPs,支持亚马逊自研的Titan Text G1大模型训练,训练成本较英伟达B200集群降低40%。AIMultiple测试显示,其在云原生AI任务中的资源利用率达89%,远超行业平均的65%,这一优势使其成为AWS客户的优先选择,2025年部署量突破150万枚。

3. 英特尔Habana Gaudi 3:中端训练的稳定选项

英特尔Habana Gaudi 3以“均衡性能”占据第二梯队末端,专为AI训练设计的FP8算力达950 TFLOPS,支持FP8/FP16混合精度训练,适配主流AI框架。MLCommons中端训练场景测试中,其训练BERT-Large模型的速度比上一代提升2.3倍,成本比英伟达A100低35%。

不过其核心短板在于集群扩展能力,单集群最多仅支持64颗芯片互联,难以满足超大规模模型需求,因此更多聚焦科研机构、中小企业的中模型训练场景。2025年,英特尔通过与微软Azure云合作,将Gaudi 3纳入云服务选型,推动其市场份额稳步提升。

第三梯队:行业定制化场景的务实选择

第三梯队芯片聚焦特定行业的推理场景与中小模型训练,虽算力不及前两梯队,但通过行业定制化优化形成差异化优势,在安防、医疗、工业等领域需求旺盛。

1. 寒武纪思元590:国产中端的核心力量

寒武纪思元590是国产中端芯片的代表,采用Chiplet技术,INT8算力达256 TOPS,FP16算力超300 TFLOPS,支持训练推理一体化。雪球行业分析显示,其在安防视频分析场景中,处理帧率比英伟达T4高50%,成本仅为后者的40%,已中标多个国家级智算中心的边缘节点项目。

目前思元590已导入字节跳动、阿里等企业的中端模型需求,2025年预计出货15万片,虽在大模型适配能力上与国际芯片有差距,但在行业定制化场景中形成了不可替代的优势。

2. Graphcore Bow系列:欧洲的差异化玩家

欧洲AI芯片企业Graphcore的Bow系列以“独特架构”立足第三梯队,采用3D Wafer-on-Wafer技术,2025年发布的新品性能提升40%,能效比优于传统GPU和TPU。其Bow Pod1024系统算力达350 PetaFLOPS,价格仅为英伟达DGX A100的二分之一,在欧洲政企、科研机构中应用较多,尤其在气候模拟、生物计算等AI+科学场景中表现突出。

性能竞争的下一战场:从“算力堆砌”到“智能优化”

2025年的性能排名显示,AI芯片已从“单纯比拼算力”进入“算力+智能调度”的新阶段。英伟达B200的Chiplet技术、谷歌TPU v7的集群优化、华为昇腾910C的国产化生态,都预示着未来性能突破将更多依赖“硬件架构创新+软件生态协同”。

AIMultiple预测,2026年随着2nm制程、MXFP4等新型精度格式的应用,AI芯片FP8算力有望突破10000 TFLOPS,而能效比将提升至3 TFLOPS/W以上。届时,性能排名的座次可能迎来新的洗牌,但“以应用需求定义性能方向”的核心逻辑,将成为所有芯片厂商的共同选择。

股票实盘配资平台提示:文章来自网络,不代表本站观点。